En statistiques, le lasso est une méthode de contraction des coefficients de la régression développée par Robert Tibshirani dans un article publié en 1996 intitulé Regression shrinkage and selection via the lasso.

Le nom est un acronyme anglais : Least Absolute Shrinkage and Selection Operator,.

Bien que cette méthode fut utilisée à l'origine pour des modèles utilisant l'estimateur usuel des moindres carrés, la pénalisation lasso s'étend facilement à de nombreux modèles statistiques tels que les modèles linéaires généralisés, les modèles à risque proportionnel, et les M-estimateurs. La capacité du lasso à sélectionner un sous-ensemble de variables est due à la nature de la contrainte exercée sur les coefficients et peut s'interpréter de manière géométrique, en statistique bayésienne ou analyse convexe.

Présentation formelle

Soit , le vecteur contenant les variables explicatives associées à l'individu , la réponse associée et les coefficients à estimer.

Modèle linéaire

Dans le cadre d'un modèle linéaire standard, les coefficients sont obtenus par minimisation de la somme des carrés des résidus.

Avec la méthode lasso, le vecteur de coefficients est également obtenu en minimisant la somme des carrés des résidus mais sous une contrainte supplémentaire :

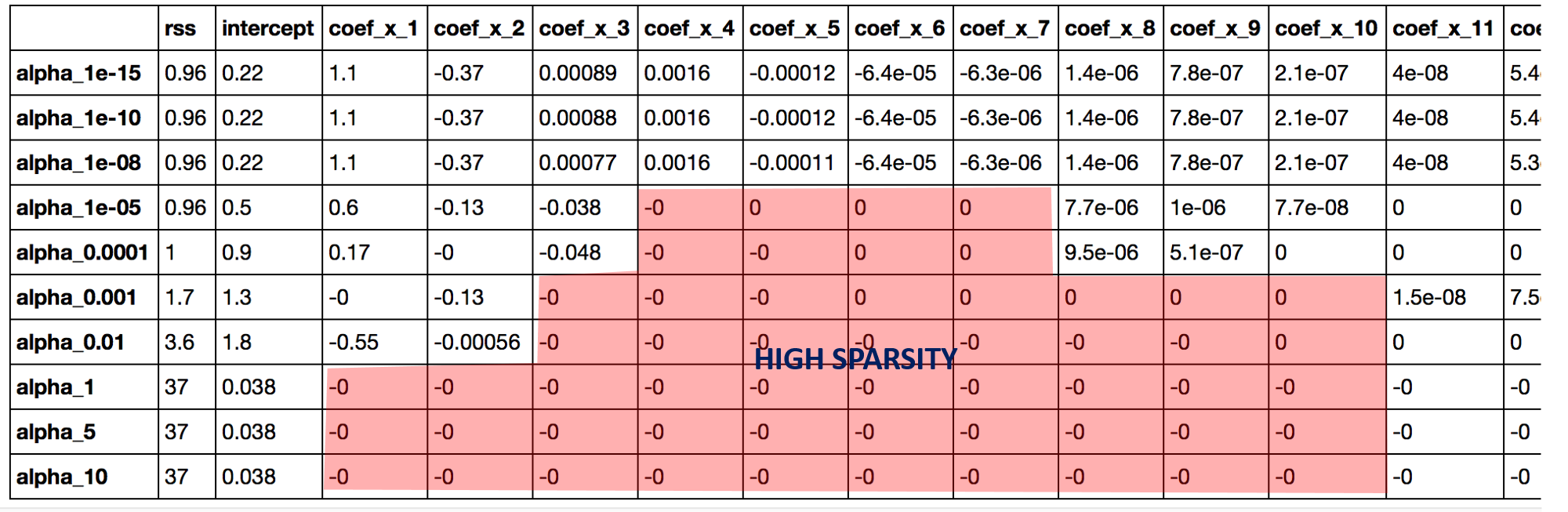

Le paramètre contrôle le niveau de régularisation des coefficients estimés.

Il s'agit d'une pénalisation de la norme des coefficients . Cette contrainte va contracter la valeur des coefficients (tout comme la régression ridge) mais la forme de la pénalité va permettre à certains coefficients de valoir exactement zéro (à l'inverse de la régression ridge).

De plus, dans des cas où le nombre de variables est supérieur au nombre d'individus , le lasso en sélectionnera au plus .

On peut écrire aussi la version lagrangienne de ce problème :

avec le paramètre de régularisation. Ce paramètre est relié au paramètre par une relation dépendante des données.

Écriture vectorielle

Soit la matrice contenant en ligne les individus, . Le lasso s'écrit généralement sous forme vectorielle, en considérant les variables centrées afin d'enlever la constante du problème :

avec la norme

La version vectorielle pour le lagrangien, quant à elle, s'écrit :

Cas orthonormal

Dans le cas où la matrice est telle que , le lasso a une solution explicite. L'estimateur lasso correspond alors à un seuillage doux de la solution des moindres carrées. Notons la solution des moindres carrées. La solution du lasso pour est :

Conditions de Karush-Kuhn-Tucker

Les conditions de Karush-Kuhn-Tucker sont des conditions qu'une solution d'un problème d'optimisation sous contraintes doit vérifier pour être optimale. Dans le cas de la version linéaire du lasso, les conditions du premier ordre sont pour :

avec la ieme colonne de la matrice et appartenant au sous-différentiel de la fonction .

Cas général

Le lasso n'est pas uniquement restreint à la régression linéaire, il peut être également utilisé avec les modèles linéaires généralisés permettant ainsi de faire de la régression logistique pénalisée. L'écriture vectorielle de la forme lagrangienne est :

avec une fonction objectif.

Par exemple, pour une régression logistique, on a :

- .

Avantages et limites du lasso

Les principaux avantages du lasso sont :

- Grande dimension : le lasso fonctionne dans les cas où le nombre d'individus est inférieur au nombre de variables , si toutefois un faible nombre de ces variables a une influence sur les observations (hypothèse de parcimonie). Cette propriété n'est pas vraie dans le cas de la régression linéaire classique avec un risque associé qui augmente comme la dimension de l'espace des variables même si l'hypothèse de parcimonie est vérifiée.

- Sélection parcimonieuse : le lasso permet de sélectionner un sous-ensemble restreint de variables (dépendant du paramètre ). Cette sélection restreinte permet souvent de mieux interpréter un modèle (rasoir d'Ockham).

- Consistance de la sélection : lorsque le vrai vecteur solution est creux , c'est-à-dire que seul un sous-ensemble de variables est utilisé pour la prédiction, sous de bonnes conditions, le lasso sera en mesure de sélectionner ces variables d'intérêts avant toutes autres variables.

Par contre, certaines limites du lasso ont été démontrées :

- Les fortes corrélations : si des variables sont fortement corrélées entre elles et qu'elles sont importantes pour la prédiction, le lasso en privilégiera une au détriment des autres. Un autre cas, où les corrélations posent problème, est quand les variables d'intérêts sont corrélées avec d'autres variables. Dans ce cas, la consistance de la sélection du lasso n'est plus assurée.

- La très grande dimension : lorsque notamment la dimension est trop élevée ( très grand comparé à ) ou le vrai vecteur n'est pas suffisamment creux (trop de variables d'intérêts), le lasso ne pourra pas retrouver l'ensemble de ces variables d'intérêts.

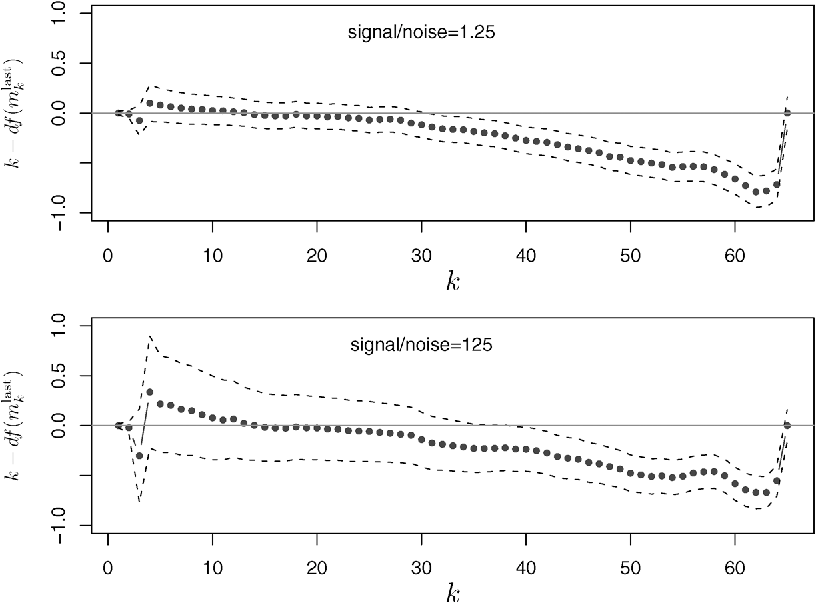

Calcul des solutions de lasso

La fonction de perte du lasso n'est pas différentiable, mais une grande variété de techniques issues de l'analyse convexe et de la théorie de l'optimisation ont été développées pour calculer le chemin des solutions du lasso. Celles-ci incluent la descente de coordonnées, les méthodes de sous-gradient, la régression par angles successifs (LARS), et les méthodes de gradient proximal. Les méthodes de sous-gradient sont la généralisation naturelle des méthodes traditionnelles telles que la descente de gradient et la descente de gradient stochastique au cas où la fonction objectif n'est pas différentiable en tous points. LARS est une méthode étroitement liée aux modèles lasso, et dans de nombreux cas permet de les ajuster efficacement, bien qu'elle puisse ne pas bien fonctionner dans toutes les circonstances. LARS génère des chemins de solutions complets. Les méthodes proximales sont devenues populaires en raison de leur flexibilité et de leurs performances et constituent un domaine de recherche actif. Le choix de la méthode dépendra de la variante particulière de lasso, des données et des ressources disponibles. Cependant, les méthodes proximales donnent généralement de bons résultats.

Le package "glmnet" en R, où "glm" fait référence aux "modèles linéaires généralisés" et "net" fait référence au "net" de "elastic net", fournit un moyen extrêmement efficace d'implémenter LASSO et certaines de ses variantes,,.

Le package "celer" en Python fournit un solveur extrêmement efficace pour le problème du Lasso, surpassant souvent les solveurs traditionnels comme scikit-learn jusqu'à 100 fois dans certains scénarios, notamment avec des ensembles de données de haute dimension. Ce package exploite des techniques d'extrapolation duale pour atteindre ses gains de performance,. Le package celer est disponible sur GitHub.

Applications

Le lasso est utilisé dans des problèmes de grande dimension (), un cas où des méthodes plus classiques ne fonctionnent pas. Le lasso dispose d'algorithmes peu coûteux en temps de calcul et de stockage, ce qui le rend d'autant plus populaire, comme en génomique où l'on peut être amené à traiter des jeux de données avec plusieurs centaines de milliers de variables.

En pratique, le lasso est testé pour différentes valeurs de . Un chemin solution représentant l'évolution des coefficients en fonction de est ainsi obtenu. La courbe d'un coefficient estimé en fonction de est linéaire par morceaux. Une fois ce chemin solution obtenu, une valeur de est choisie par des méthodes comme la validation croisée ou un critère d'information (AIC par exemple).

Extensions

Un certain nombre de variantes du lasso ont été créées pour étendre la méthode à différents cas pratiques ou pour pallier certaines limitations du lasso. Sont présentées ici les variantes les plus courantes.

Elastic-Net

L'Elastic-net a été introduit afin de surmonter deux "limitations" du lasso. Premièrement, le lasso ne peut sélectionner qu'au plus variables dans le cas où . Deuxièmement, en présence d'un groupe de variables fortement corrélées, le lasso ne sélectionne généralement qu'une seule variable du groupe. L'idée est donc d'ajouter au lasso une pénalité ridge. Ainsi l'objectif de l'Elastic-Net est :

avec et .

Fused-lasso

Le Fused-Lasso permet de prendre en compte la spatialité des variables. Le principe est que les variables "proches" aient des coefficients estimés "proches". Cela est possible en pénalisant la norme de la différence de deux coefficients successifs. De la même manière que pénaliser la norme d'un coefficient a tendance à produire des coefficients égaux à 0, pénaliser la différence va favoriser l'égalité de deux coefficients successifs. L'objectif du Fused-Lasso est alors :

avec et .

Group-Lasso

L'idée du Group-Lasso est d'avoir une méthode fournissant une sélection parcimonieuse de groupes (fournis a priori) et non de variables. Soit , une partition des variables en groupes. On note , pour , le vecteur restreint aux éléments du groupe . L'objectif du Group-Lasso est :

avec , le paramètre de régularisation et , un poids associé au groupe (généralement ).

Notes et références

Voir aussi

Lien interne

- Acquisition comprimée

Liens externes

- The Lasso Page sur le site web de Robert Tibshirani

- Portail des probabilités et de la statistique